“Crawl budget?! Maar SEO was toch gratis?!”

We snappen dat je de eerste keer dat je deze term hoort in paniek raakt. Het is ook een term waar je online niet al te veel over leest. Hoe dat kan? Het is namelijk geen direct ranking factor. Maar dat maakt het zeker niet minder belangrijk. Maar wat is dat crawl budget dan? En hoe optimaliseer je het? We vertellen je er alles over!

Wat is crawl budget?

Het crawl budget geeft aan hoeveel pagina’s van jouw website Google crawlt. Een hoger crawl budget betekent dat er meer pagina’s geïndexeerd kunnen worden.

Tot zover de letterlijke definitie. Maar om echt goed te begrijpen wat crawl budget is, is het zaak om eerst in te zoomen op het begrip crawlen. Crawlen staat letterlijk vertaald voor kruipen. De bots van een zoekmachine kruipen letterlijk door jouw website heen en nemen alles wat ze tegenkomen in zich op. Niet alleen beoordelen ze alles wat ze op hun weg tegenkomen, ook indexeren ze dit. (Of niet, maar dat ligt dan aan een te laag crawl budget)

Waar kijkt Google naar?

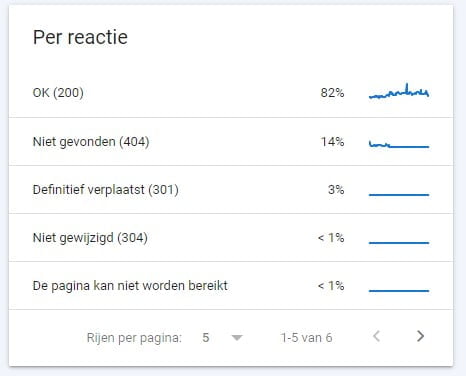

Om een eerste beeld te krijgen van de manier waarop Google jouw crawl budget bepaalt, duiken we dieper in het brein van Google. En dat brein is Google Search Console. Met deze tool geeft de zoekmachine jou een kijkje in de keuken. Open in GSC het ‘rapport crawlstatistieken’ en je krijgt direct een inzicht in de crawl verzoeken. Kijk naar ‘per reactie’ en je ziet direct welke crawl verzoeken er allemaal hebben plaatsgevonden. Dit project heeft 82% succesvolle crawl verzoeken. 18% van het ‘budget’ gaat op aan verspilde resultaten. Dit is weggegooid budget. In dit geval gaat het om 404-pagina’s, (301) redirects en overigen.

Google beoordeelt eigenlijk op drie manieren wat en hoe er gecrawld wordt. Dit zie je bovenaan de pagina crawlstatistieken. Dit is namelijk opgedeeld in:

- Totaal aantal crawl verzoeken (autoriteit)

- Totale download grootte (techniek)

- Gemiddelde reactietijd (server)

Autoriteit

Als de autoriteit van jouw website groeit, stijgt het crawl budget. Oké, dit is misschien ietwat zwart wit gedacht, maar is wel grotendeels waar. Denk er maar eens over na, het is eigenlijk best logisch:

Als het aantal (betrouwbare) links naar jouw website toeneemt, komen de crawlers van Google vaker op jouw website. En elke keer dat ze toch op jouw website zijn, pakken ze direct maar wat pagina’s mee.

Techniek

De crawlers van Google proeven tijdens het crawlen steeds kleine stukjes van jouw website. Toch hebben ze maar een klein maagje. Je moet ze dus niet al te grote gerechten serveren.

Hmm, leuke metafoor, maar misschien toch maar op een andere manier verwoorden.

Een website biedt informatie. Een browser moet deze informatie kunnen verwerken. Een zoekmachine dus ook. Als een webpagina veel MB groot is, hebben zowel de browser als zoekmachine moeite om deze te consumeren. Je wilt dan ook zorgen voor een zo licht mogelijke website, zodat beiden zo efficiënt en snel mogelijk door jouw website heen kunnen. Over die efficiëntie volgt later ook nog meer.

Server

Tot slot willen de bots van Google niet dat jouw servers overbelast raken. Om dit te voorkomen, berekenen ze wat de crawl capaciteit is van jouw website. Ze berekenen hoeveel verzoeken ze tegelijkertijd kunnen sturen. Daarbij berekenen ze hoe lang de tijd tussen de verschillende verzoeken is. Een snellere server = een hoger crawl budget!

Zo optimaliseer je het crawl budget van jouw website!

Als we het crawl budget van onze website willen optimaliseren, houden we de drie bovengenoemde onderdelen in het achterhoofd. We denken dus aan autoriteit, techniek en de server. En dit doen we door op de volgende vier onderdelen te letten!

1. Robots.txt-bestand fixen

Het robots.txt-bestand is hét instructie bestand voor bots en zoekmachines. Er wordt geen pixel of URL bekeken zonder dat dit bestandje is geraadpleegd. Vanaf deze centrale plek kun je dan ook het meeste invloed uitoefenen op de hulpjes van Google. Zo geef je niet alleen aan wie (User-agent) en wat ze wel (Allow) mogen bekijken. Je geeft ook aan wat ze niet mogen bekijken. Dit doe je door het Disallow-kenmerk in te vullen.

“Maar goed. Heel leuk die theorie. Ik wil alleen weten waarvoor ik dit moet inzetten.”

Dit doe je door overbodige pagina’s of bestanden te disallowen. Denk bijvoorbeeld aan een zoekfunctie op jouw website. Met iedere zoekopdracht wordt een aparte parameter gegenereerd. Hartstikke handig voor bezoekers, maar niet de content die je door Google gecrawld of geïndexeerd wilt hebben. Disallow dit soort pagina’s dan ook. Dit scheelt onwijs!

2. Voorkom duplicate content en broken links

Je wilt dat crawlers zo efficiënt mogelijk door jouw website kunnen bewegen. Voorkom afleiding en verspilling van het budget door op enkele technische onderdelen te letten:

404-pagina’s: een 404-pagina (bijvoorbeeld door een broken link) zorgt voor verspilling van crawl budget. Een crawler bezoekt namelijk een pagina waar het niks aan heeft. Bovendien is het veelal een eindpunt, waardoor er niet verder gecrawld wordt.

Duplicate content: iedere pagina telt. Duplicate content zorgt dan ook voor het consumeren van onnodige informatie. Hierdoor lever je onnodig budget in. Budget wat ook voor andere pagina’s gebruikt had kunnen worden.

Canonicals: grote webshops maken vaak gebruik van paginatie. Pagina 3 van de broeken heeft hetzelfde doel als pagina 1. Er staan alleen wat andere producten op. Ook dit zorgt dus voor onnodig budget en onnodige ruis op de lijn.

3. Nofollow links

Het disallowen is een harde maatregel. Dit doe je voor pagina’s die je echt niet gecrawld wilt hebben. Bepaalde pagina’s daarentegen wil je wel gecrawld hebben, maar misschien niet zo vaak. Voor een bezoeker heeft een linkje naar een pagina misschien wel een meerwaarde, maar voor zoekmachines niet. Heeft jouw website dan ook talloze interne links, dan is het misschien handig om zoekmachines een beetje te begeleiden. Dit doe je door het ‘Rel=”nofollow”-kenmerk’ mee te geven aan een link. Denk aan links naar:

- Contact

- Winkelmandje

- Disclaimer, cookieverklaring, algemene voorwaarden etc.

4. Zorg dat een crawler zo min mogelijk tijd en moeite kwijt is

Tot slot is het zaak dat een crawler zo min mogelijk tijd en moeite kwijt is. Via stap twee heb je het oponthoud al voorkomen. Nu nog zorgen voor een soepel verloop. Dit begint bij het zo klein mogelijk maken van de grootte van een pagina. Dit zit hem vooral in het verkleinen van afbeeldingen. Hierdoor kunnen server requests zo snel mogelijk afgehandeld worden. Vervolgens wil je ook dat de daadwerkelijke communicatie met de server zo goed mogelijk verloopt. Dit is vaak zeer technisch van aard en kun je het beste afstemmen met jouw hostingprovider.

Een klein onderdeel waar men vaak overheen kijkt, is het aantal redirects. Weliswaar is een redirect een prima pleister op de wond, maar het zorgt wel voor vertraging. Een crawler bezoekt namelijk eerst het oude adres, waarna het doorgestuurd wordt naar het nieuwe adres. Eigenlijk bekijkt het dus twee pagina’s, waar het er maar een zou moeten bekijken. We willen je dan ook vragen om zorgvuldig met redirects om te gaan. Soms ontkom je er niet aan en is het zelfs beter om geen autoriteit te verliezen, maar het zorgt ook voor vertraging en daarmee dus verspilling van crawl budget!

Conclusie

Al met al is crawl budget geen direct ranking factor. Maar het gaat je op den duur wel helpen met jouw rankings. Hiervoor moet je twee dingen doen: het crawl budget zo hoog mogelijk maken en het crawl budget zo efficiënt mogelijk inzetten. Twijfel je of je dit voor jouw website of webshop wel goed hebt gedaan? Neem eens vrijblijvend contact met ons op en we helpen je graag verder!